Ispravni roboti txt za html stranice stvaraju rasporede akcija za robote tražilica, govoreći im da mogu provjeriti. Često se ova datoteka naziva protokol za uklanjanje robota. Prva stvar koja traži robote prije indeksiranja web-lokacije je robots.txt. On može pokazati na Sitemap ili ga obavijestiti da nije provjerio određene poddomene. Robots.txt nije potreban kada tražilice traže najčešće korištene. U tom je procesu vrlo važno da datoteka bude ispravno formatirana i da ne smije indeksirati svoju stranicu s osobnim podacima korisnika.

Princip skeniranja robota

Kada tražilica upozna datoteku i vidi zabranjenu URL adresu, neće je skenirati, ali je može indeksirati. To je zbog činjenice da čak i ako roboti ne smiju pregledavati sadržaj, mogu se sjetiti povratnih veza koje upućuju na odbijenu URL adresu. Zbog blokiranog pristupa vezi, URL adresa će se pojaviti u tražilicama, ali bez isječaka. Ako ulazna marketinška strategija zahtijeva ispravan robot txt za bitrix, provjerite mjesto na zahtjev korisnika od strane skenera.

S druge strane, ako je datoteka formatirana na pogrešan način, to može rezultirati time da stranica nije prikazana u rezultatima pretraživanja i neće biti pronađena. Ova datoteka tražilice ne može se zaobići. Programer može pregledati datoteku robots.txt bilo koje web-lokacije tako da ode na svoju domenu i slijedi je na primjer pomoću datoteke robots.txtwww.domain.com/robots.txt. Korištenjem takvog alata kao što je SEO Unamo dio, u koji možete unijeti bilo koju domenu, a usluga će prikazati informacije o prisutnosti datoteke. Ograničenja za skeniranje:

Korisnik ima zastarjeli ili povjerljivi sadržaj. Slike na stranici neće biti uključene u rezultate pretraživanja slika. Mjesto još nije spremno za demonstraciju koju robot treba indeksirati.Treba imati na umu da je informacija koju korisnik želi primiti od tražilice dostupna svakome tko unese URL. Ne biste trebali koristiti ovu tekstualnu datoteku za skrivanje osjetljivih podataka. Ako domena ima pogrešku od 404 (nije pronađena) ili 410 (prošla), tražilica provjerava web-lokaciju, unatoč prisutnosti robots.txt u ovom slučaju, vjeruje da datoteka nedostaje. Druge pogreške, kao što je 500 (Interna pogreška poslužitelja), 403 (Zabranjeno), time-out ili "nedostupan", uzimaju u obzir upute za robots.txt, ali obilaznica se može odgoditi dok datoteka ne bude dostupna.

Napravi datoteku za pretraživanje

Mnoge CMS aplikacije, kao što je WordPress, već posjeduju datoteku robots.txt. Prije nego što ispravno konfigurirate Robots txt WordPress, morate se upoznati s njegovim mogućnostima kako biste saznali kako mu pristupiti. Ako programer sam kreira datoteku, mora ispuniti sljedeće uvjete:

Mora biti napisano malim slovima. Koristite kodiranje UTF-8. Za spremanje datoteke (.txt) u uređivač teksta.Kada korisnik ne zna gdje ga postaviti, kontaktirat će svog dobavljača softveraPružanje web-poslužitelja za učenje kako pristupiti korijenu domene ili otići na Google konzolu i preuzeti je. Pomoću ove značajke Google također može provjeriti radi li bot ispravno i popis web-lokacija koje su blokirane upotrebom datoteke.

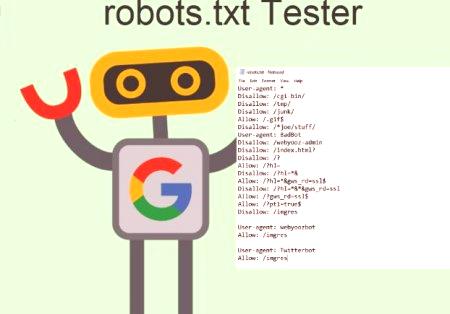

Osnovni format ispravnog robota txt za bitrix:

Legenda robots.txt. #, komentari koji se koriste samo kao bilješke. Ovi će komentari biti zanemareni od strane skenera zajedno s pogreškama korisnika. User-agent - Označava na kojem pretraživaču su navedene upute za datoteku. Dodavanje zvjezdice (*) govori skenerima da su upute stvorene za svakoga.Odredite određeni bot, kao što je Googlebot, Baiduspider, Applebot. Disallow, govori skenerima koji dijelovi web-mjesta ne moraju skenirati. Izgleda ovako: User-agent: *. Zvijezda znači "svi roboti". Međutim, možete specificirati stranice za određene robote. Da biste to učinili, morate znati ime bota, za koji su postavljene preporuke. Ispravni roboti txt za Yandex mogu izgledati ovako:

Ako bot ne mora zaobići stranicu, možete ga specificirati, a kako bi pronašli imena korisničkih agenata, preporučuje se da se upoznate s mogućnostima useragentstring.com online.

Optimizacija stranica

Dvije takve linije smatraju se cjelovitom robots.txt datotekom, s jednom robot datotekom koja sadrži nekoliko redova korisničkih agenta i smjernica koje zabranjuju ili dopuštaju indeksiranje. Glavni format ispravnog robota txt:

Korisnički agent: [korisničko ime korisnika]. Disallow: [URL koji nije skeniran].U datoteci se svaki blok smjernica prikazuje kao diskretna, odvojena linija. U datoteci, zajedno s korisničkim imenikom agenta, svako se pravilo koristi s obzirom na određeni skup particioniranih nizova. Ako datoteka ima pravilo koje se odnosi na više agenata, robot će razmotriti samo najprecizniju skupinu uputa.

Tehnička sintaksa

Može se promatrati kao "jezik" robots.txt datoteka. U ovom formatu može postojati pet pojmova, od kojih su glavni:

User-agent je web pretraživač s uputom za indeksiranje, obično tražilicom. Disallow - Naredba koja se koristi za usmjeravanje korisnika na agenta potrebe (pass) određenog URL-a. Za svakoga postoji samo jedno zabranjeno stanje. Dopusti. Za Googlebot koji pristupa, čak je i prilagođena stranica zabranjena. Crawl-delay - Određuje koliko će sekundi prijeći skener. Kada ga bot ne potvrdi, brzina se postavlja u Google konzoli. Sitemap - koristi se za određivanje lokacije mapa povezanih s XML-om povezanih s URL-om. Usporedba modela

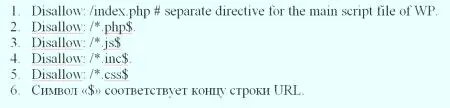

Kada je riječ o stvarnim URL-ovima blokiranja ili dopuštenja ispravnog robota txt, operacije mogu biti prilično komplicirane, jer vam omogućuju da koristite uzorak podudaranja kako biste dosegli brojne moguće parametre URL-a. I Google i Bing koriste dva znaka koji identificiraju stranice ili podmape koje SEO želi izuzeti. Ta dva znaka imaju zvjezdicu (*) i znak dolara ($), gdje: * je znakzamjena, koja predstavlja bilo koji slijed znakova. $ - odgovara kraju URL-a.

Google nudi veliki popis mogućih sintaksa za zadatke predložaka koje objašnjavaju korisniku kako konfigurirati datoteku Robots txt. Neke uobičajene upotrebe uključuju:

Sprečavanje ponavljanja sadržaja u rezultatima pretraživanja. Privatno čuvanje svih dijelova web-mjesta. Spremanje internih stranica rezultata pretraživanja na temelju otvorene izjave. Naznaka mjesta.

Sprječavanje tražilica za indeksiranje određenih datoteka. Označava premos za zaustavljanje za zaustavljanje preopterećenja dok istovremeno skenira nekoliko područja sadržaja.

Provjera prisutnosti robotske datoteke

Ako nema zona za skeniranje, tada robots.txt uopće neće biti potreban. Ako korisnik nije siguran što je ova datoteka, treba je unijeti u korijensku domenu i upisati kraj URL-a, otprilike: moz.com/robots.txt. Brojne tražilice zanemaruju te datoteke. Međutim, u pravilu, ovi skeneri ne pripadaju autoritativnim tražilicama. Oni dolaze iz raznih spamera, poštanskih agregata i drugih vrsta automatiziranih robota, koji su široko dostupni na internetu. Važno je zapamtiti da upotreba standarda za isključivanje robota nije učinkovita mjera sigurnosti. Zapravo, neki roboti mogu početi sa stranicama na kojima korisnik postavlja svoj način skeniranja. Postoji nekoliko dijelova koji su uključeni u standardnu datoteku isključenja. Prije nego što kažem posao na kojemstranica ne bi trebala raditi, morate navesti koji robot govoriti. U većini slučajeva korisnik će koristiti jednostavnu deklaraciju, što znači "svi roboti".

Optimizacija SEO

Prije optimizacije, korisnik se mora pobrinuti da ne blokira bilo koji sadržaj ili dijelove web-mjesta koje je potrebno zaobići. Neće se poštivati veze na stranice blokirane ispravnim robotovima txt. To znači:

Ako se ne odnose na druge stranice koje su dostupne tražilicama, to jest, stranice nisu blokirane robots.txt ili meta-robotom, a povezani resursi neće biti skenirani i stoga se neće moći indeksirati. Nijedna se veza ne može prenijeti s zaključane stranice na odredišnu vezu. Ako postoji takva stranica, najbolje je koristiti drugi mehanizam zaključavanja od robots.txt.Budući da se druge stranice mogu izravno povezati na stranicu koja sadrži osobne podatke i želite blokirati ovu stranicu iz rezultata pretraživanja, koristite drugu metodu, kao što su zaštita lozinkom ili metapodaci noindex podaci. Neke tražilice imaju nekoliko prilagođenih agenata. Na primjer, Google koristi Googlebot za standardno pretraživanje i Googlebot-Image za pretraživanje slika. Većina prilagođenih agenata iz iste tražilice slijedi ista pravila, tako da nema potrebe za određivanjem direktiva za svaki od nekoliko pretraživačkih robota, ali imaju mogućnost da to urade precizno konfiguriraju provjeru sadržaja stranice. Tražilica spremasadržaj datoteke i obično ažurira sadržaj predmemorije barem jednom dnevno. Ako korisnik promijeni datoteku i želi je ažurirati brže nego što je standardna, može poslati robots.txt URL Googleu.

Tražilice

Da biste razumjeli kako robot txt radi ispravno, morate znati o mogućnostima tražilice. Ukratko, njihove sposobnosti leže u činjenici da šalju "skenere", koji su programi koji pretražuju internet radi informacija. Zatim neke podatke pohranjuju kako bi ih kasnije proslijedili korisniku. Za mnoge je Google internet. Zapravo, oni su u pravu, jer je to možda njegov najvažniji izum. Iako su se tražilice uvelike promijenile od svog stvaranja, njihova osnovna načela su ista. Skeneri, također poznati kao "roboti" ili "pauci", pronalaze stranicu od milijardi web stranica. Tražilice im daju upute o tome kamo ići, dok pojedinačne web-lokacije također mogu komunicirati s robotima i reći im koje specifične stranice trebaju gledati. Vlasnici stranica u pravilu ne žele prikazivati na tražilicama: administrativne stranice, pozadinske portale, kategorije i oznake, kao i druge stranice s informacijama. Također možete koristiti datoteku robots.txt tako da tražilice ne skeniraju stranice. Ukratko, robots.txt govori web pretraživačima što da rade.

Zabranjene stranice

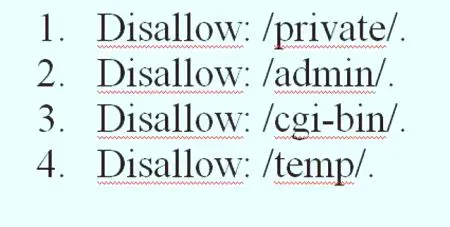

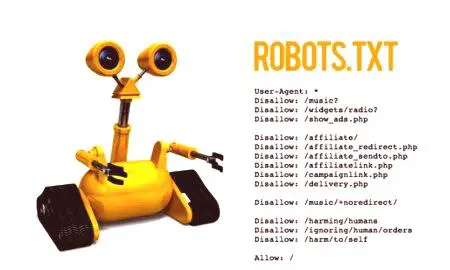

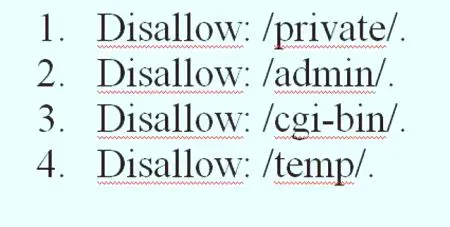

Ovo je većina datoteke za isključivanje robota. Jednostavnim oglasom korisnik određuje bot ili grupu botova tako da ne indeksiraju određenestranica. Sintaksa je jednostavna, na primjer, zabraniti pristup svemu u direktoriju "admin" stranice je napisano: Disallow: /admin. Ovaj redak spriječit će robote da indeksiraju yoursite.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html i sve ostalo što spada u direktorij administratora. Da biste zabranili jednu stranicu, jednostavno je usmjerite na traku: Disallow: /public/exception.html. Sada stranica "iznimka" neće biti premještena, već sve ostalo u "javnoj" mapi. Da biste uključili više stranica, jednostavno ih navedite:

Ova četiri retka ispravnog robota txt za simfoniju primjenjivat će se na svakog korisnika agenta navedenog na vrhu odjeljka # robots.txt za https://www.symphonyspace.org/.

Sitemap: https://www.symphonyspace.org/sitemaps/1/sitemap.xml. Ostale naredbe: # live - nemojte dopustiti indeksiranje cpresources /ili davatelja usluga /. Custom agent: * Disallow: /cpresources /. Disallow: /Proizvođač /Disallow: /.env.

Postavljanje standarda

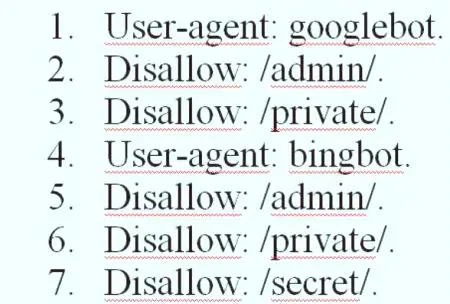

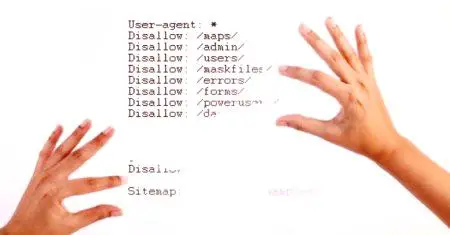

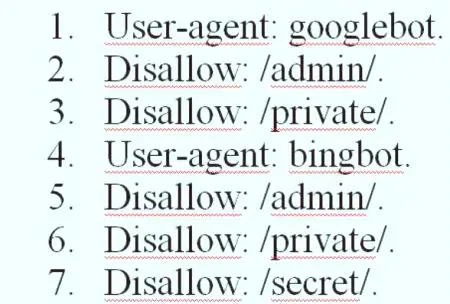

Korisnik može specificirati određene stranice za različite botove, kombinirajući prethodna dva elementa, tako izgleda. Primjer ispravnog robota txt za sve tražilice je prikazan u nastavku.

Odjeljci "admin" i "private" su nevidljivi za Google i Bing, ali Google će i dalje vidjeti tajni direktorij, dok Bing to neće učiniti. Možete odrediti opća pravila za sve robote pomoću korisničkog agenta zvjezdicom, a zatim u sljedećim odjeljcima dati konkretne upute robotima. Uz znanje gore navedeno, korisnik može napisati primjer ispravnog robota txt za sve tražilice. Jednostavno pokrenite svoj omiljeni uređivač teksta iObavijestite botove da nisu dobrodošli u određenim dijelovima stranice.

Savjeti za povećanje performansi poslužitelja

SublimeText je svestrani uređivač teksta i zlatni standard za mnoge programere. Osim toga, softverski savjeti temelje se na učinkovitom kodiranju. korisnici cijene prisutnost prečaca u programu. Ako korisnik želi vidjeti primjer datoteke robots.txt, idite na bilo koju web-lokaciju i dodajte "/robots.txt" na kraj. Ovdje je dio datoteke GiantBicycles robots.txt. Program omogućuje stvaranje stranica koje korisnici ne žele prikazati na tražilicama. I također ima neke ekskluzivne stvari o kojima malo ljudi zna. Na primjer, ako datoteka robots.txt kaže botovima gdje ne morate ići, Sitemap čini suprotno i pomaže im da pronađu ono što traže, a iako tražilice vjerojatno već znaju gdje je karta web-lokacije, ona ih ne ometa. Postoje dvije vrste datoteka: HTML stranica ili XML datoteka. HTML stranica je ona koja posjetiteljima prikazuje sve postojeće stranice na web-lokaciji. U vlastitoj datoteci robots.txt izgleda ovako: Sitemap: //www.makeuseof.com/sitemap_index.xml. Ako web-lokacija nije indeksirana na tražilicama, iako je nekoliko puta pretraživana web-pretraživačima, morate provjeriti je li datoteka ispravno postavljena. Po defaultu, to će se dogoditi sa svim SeoToaster instalacijama, ali ako je potrebno, možete ga vratiti na sljedeći način: Datoteka robots.txt - 644. Ovisno o PHP poslužitelju, ako ne radi za korisnika, preporučuje se pokušati sljedeće: Datoteka robots.txt - 666

Podešavanje kašnjenja skeniranja

Direktiva o odgađanju skeniranjagovori određenim tražilicama koliko često mogu indeksirati stranicu na web-lokaciji. Mjeri se u sekundama, iako neke tražilice tumače nešto drugačije. Neki vide kašnjenje od 5 zaobilazeći kada im kažu da pričekaju pet sekundi nakon svakog skeniranja kako bi započeli sljedeći. Drugi to tumače kao uputu za skeniranje samo jedne stranice svakih pet sekundi. Robot ne može brže skenirati kako bi spasio propusnost poslužitelja. Ako poslužitelj mora odgovarati prometu, može postaviti odgodu putovanja. Općenito, u većini slučajeva korisnici ne moraju brinuti o tome. Evo kako je kašnjenje indeksiranja od 8 sekundi postavljeno na Crawl-delay: 8. Ali neće sve tražilice slijediti ovu direktivu, tako da kada zabranite stranice, možete postaviti različita kašnjenja za određena tražilice. Kada se sve upute u datoteci konfiguriraju, možete ih preuzeti na web-lokaciji, prvo provjerite je li riječ o jednostavnoj tekstualnoj datoteci i nazivu robots.txt, a mogu se pronaći na yoursite.com/robots.txt.

Najbolji WordPress Bot

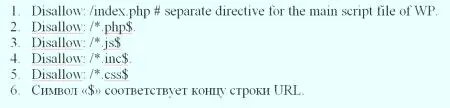

WordPress ima neke datoteke i direktorije koji moraju biti blokirani svaki put. Katalozi koje korisnici moraju zabraniti - to je katalog standardnih WP direktorija tvrtke cgi-bin. Neki poslužitelji ne dopuštaju pristup cgi-bin direktoriju, ali ga korisnici moraju uključiti u direktivu disallow prije ispravnog konfiguriranja robota txt WordPressa. Ti direktoriji nemaju podatke koji su u početku korisni za tražilicesustavima, ali postoji iznimka, to jest, u direktoriju wp-content postoji poddirektorij pod nazivom prijenosi. Ovaj poddirektorij mora biti dopušten u datoteci robot.txt jer uključuje sve što se učitava pomoću značajke prijenosa WP medija. WordPress koristi oznake ili kategorije za strukturiranje sadržaja. Ako se koriste kategorije, kako bi se napravili ispravni roboti txt za Wordpress, kako je odredio proizvođač programa, potrebno je zaključati arhive oznaka za pretraživanje. Najprije provjerite bazu podataka tako da odete na upravljačku ploču & gt; Postavke & gt; "Permalink". Prema zadanim postavkama baza je oznaka ako je polje prazno: Disallow: /tag /. Ako koristite kategoriju, morate blokirati kategoriju u datoteci robot.txt: Disallow: /category /. Prema zadanim postavkama baza je oznaka ako je polje prazno: Disallow: /tag /. Ako koristite kategoriju, morate blokirati kategoriju u datoteci robot.txt: Disallow: /category /. Datoteke koje se uglavnom koriste za prikazivanje sadržaja blokirane su ispravnom robot txt datotekom za Wordpress:

Glavna instalacija Joomle

Jednom kada korisnik instalira Joomlu, trebate vidjeti ispravnu konfiguraciju globalne konfiguracije Robots txt Joomla, koja se nalazi na upravljačkoj ploči. Neke od postavki ovdje su vrlo važne za SEO. Najprije pronađite naziv web-lokacije i provjerite koristi li se kratki naziv web-lokacije. Tada su pronašli skup postavki na desnoj strani zaslona, pod nazivom SEO postavke. Ono što svakako morate promijeniti je drugo: koristite URL prepisivanja. Zvuči teško, ali u osnovi toPomaže Joomli u stvaranju čišćih URL-ova. Najvažnije, ako uklonite liniju index.php iz URL-ova. Ako ga kasnije promijenite, URL-ovi će se promijeniti i Google se neće svidjeti. Međutim, kada promijenite ovu opciju, trebate napraviti nekoliko koraka za stvaranje ispravnog robota txt za Joomla:

U korijenskom direktoriju Joomla, pronađite htaccess.txt datoteku. Označite ga kao .htaccess (nema produžetka). Uključite naslov web-lokacije u naslove stranica. Pronađite postavke metapodataka na dnu zaslona za globalnu konfiguraciju. Robot u oblaku MODX

Ranije je MODX Cloud omogućio korisnicima da kontroliraju ponašanje datoteke robots.txt radi održavanja na temelju prebacivanja u nadzornu ploču. Iako je to bilo korisno, mogli biste nasumce dopustiti indeksiranje na stranicama /dev stranicama prebacivanjem opcije na nadzornu ploču. Slično tome, indeksiranje na mjestu proizvodnje može se lako zabraniti. Danas usluga razmatra prisutnost datoteka robots.txt u datotečnom sustavu uz sljedeće iznimke: domena koja završava, modxcloud.com poslužit će kao smjernica Disallow: /za sve korisničke agente, bez obzira na prisutnost ili odsutnost datoteke. Za proizvodne web-lokacije koje primaju prave posjetitelje prometa, morat ćete koristiti vlastitu domenu ako korisnik želi indeksirati njihovu web-lokaciju. Neke organizacije koriste ispravan robots txt za modx za pokretanje više web-mjesta iz jedne instalacije pomoću konteksta. Slučaj u kojem se to može primijeniti bit će javni marketingweb-lokaciju u kombinaciji s mikro-stranicama odredišne stranice i, možda, nejavnim intranetom. Tradicionalno, to je bilo teško za instalacije s više korisnika, budući da dijele isti korijen mreže. MODX Cloud može to učiniti lako. Samo prenesite dodatnu datoteku na web-mjesto pod nazivom robots-intranet.example.com.txt s takvim sadržajem i blokirat će indeksiranje pomoću robota koji dobro funkcioniraju, a sva ostala imena hostova vraćaju se u standardne datoteke ako nema drugih specifičnih nazvanih čvorova. Robots.txt važna je datoteka koja korisniku pomaže povezati se s web-lokacijom na Googleu, glavnim pretraživačima i drugim web-lokacijama. Nalazi se u korijenu web-poslužitelja - datoteka upućuje web-pretraživače na indeksiranje web-lokacije, koja postavlja sve mape koje bi trebale indeksirati ili ne bi trebale indeksirati, pomoću skupa uputa koje se nazivaju protokol za uklanjanje robota. Primjer ispravnog robota txt za sve tražilice obots.txt je posebno jednostavan uz SeoToaster. Ima poseban izbornik na upravljačkoj ploči, tako da bot nikada neće morati naprezati da bi dobio pristup.

Prije optimizacije, korisnik se mora pobrinuti da ne blokira bilo koji sadržaj ili dijelove web-mjesta koje je potrebno zaobići. Neće se poštivati veze na stranice blokirane ispravnim robotovima txt. To znači:

Prije optimizacije, korisnik se mora pobrinuti da ne blokira bilo koji sadržaj ili dijelove web-mjesta koje je potrebno zaobići. Neće se poštivati veze na stranice blokirane ispravnim robotovima txt. To znači: Da biste razumjeli kako robot txt radi ispravno, morate znati o mogućnostima tražilice. Ukratko, njihove sposobnosti leže u činjenici da šalju "skenere", koji su programi koji pretražuju internet radi informacija. Zatim neke podatke pohranjuju kako bi ih kasnije proslijedili korisniku. Za mnoge je Google internet. Zapravo, oni su u pravu, jer je to možda njegov najvažniji izum. Iako su se tražilice uvelike promijenile od svog stvaranja, njihova osnovna načela su ista. Skeneri, također poznati kao "roboti" ili "pauci", pronalaze stranicu od milijardi web stranica. Tražilice im daju upute o tome kamo ići, dok pojedinačne web-lokacije također mogu komunicirati s robotima i reći im koje specifične stranice trebaju gledati. Vlasnici stranica u pravilu ne žele prikazivati na tražilicama: administrativne stranice, pozadinske portale, kategorije i oznake, kao i druge stranice s informacijama. Također možete koristiti datoteku robots.txt tako da tražilice ne skeniraju stranice. Ukratko, robots.txt govori web pretraživačima što da rade.

Da biste razumjeli kako robot txt radi ispravno, morate znati o mogućnostima tražilice. Ukratko, njihove sposobnosti leže u činjenici da šalju "skenere", koji su programi koji pretražuju internet radi informacija. Zatim neke podatke pohranjuju kako bi ih kasnije proslijedili korisniku. Za mnoge je Google internet. Zapravo, oni su u pravu, jer je to možda njegov najvažniji izum. Iako su se tražilice uvelike promijenile od svog stvaranja, njihova osnovna načela su ista. Skeneri, također poznati kao "roboti" ili "pauci", pronalaze stranicu od milijardi web stranica. Tražilice im daju upute o tome kamo ići, dok pojedinačne web-lokacije također mogu komunicirati s robotima i reći im koje specifične stranice trebaju gledati. Vlasnici stranica u pravilu ne žele prikazivati na tražilicama: administrativne stranice, pozadinske portale, kategorije i oznake, kao i druge stranice s informacijama. Također možete koristiti datoteku robots.txt tako da tražilice ne skeniraju stranice. Ukratko, robots.txt govori web pretraživačima što da rade. Ova četiri retka ispravnog robota txt za simfoniju primjenjivat će se na svakog korisnika agenta navedenog na vrhu odjeljka # robots.txt za https://www.symphonyspace.org/.

Ova četiri retka ispravnog robota txt za simfoniju primjenjivat će se na svakog korisnika agenta navedenog na vrhu odjeljka # robots.txt za https://www.symphonyspace.org/.

Odjeljci "admin" i "private" su nevidljivi za Google i Bing, ali Google će i dalje vidjeti tajni direktorij, dok Bing to neće učiniti. Možete odrediti opća pravila za sve robote pomoću korisničkog agenta zvjezdicom, a zatim u sljedećim odjeljcima dati konkretne upute robotima. Uz znanje gore navedeno, korisnik može napisati primjer ispravnog robota txt za sve tražilice. Jednostavno pokrenite svoj omiljeni uređivač teksta iObavijestite botove da nisu dobrodošli u određenim dijelovima stranice.

Odjeljci "admin" i "private" su nevidljivi za Google i Bing, ali Google će i dalje vidjeti tajni direktorij, dok Bing to neće učiniti. Možete odrediti opća pravila za sve robote pomoću korisničkog agenta zvjezdicom, a zatim u sljedećim odjeljcima dati konkretne upute robotima. Uz znanje gore navedeno, korisnik može napisati primjer ispravnog robota txt za sve tražilice. Jednostavno pokrenite svoj omiljeni uređivač teksta iObavijestite botove da nisu dobrodošli u određenim dijelovima stranice. WordPress ima neke datoteke i direktorije koji moraju biti blokirani svaki put. Katalozi koje korisnici moraju zabraniti - to je katalog standardnih WP direktorija tvrtke cgi-bin. Neki poslužitelji ne dopuštaju pristup cgi-bin direktoriju, ali ga korisnici moraju uključiti u direktivu disallow prije ispravnog konfiguriranja robota txt WordPressa. Ti direktoriji nemaju podatke koji su u početku korisni za tražilicesustavima, ali postoji iznimka, to jest, u direktoriju wp-content postoji poddirektorij pod nazivom prijenosi. Ovaj poddirektorij mora biti dopušten u datoteci robot.txt jer uključuje sve što se učitava pomoću značajke prijenosa WP medija. WordPress koristi oznake ili kategorije za strukturiranje sadržaja. Ako se koriste kategorije, kako bi se napravili ispravni roboti txt za Wordpress, kako je odredio proizvođač programa, potrebno je zaključati arhive oznaka za pretraživanje. Najprije provjerite bazu podataka tako da odete na upravljačku ploču & gt; Postavke & gt; "Permalink". Prema zadanim postavkama baza je oznaka ako je polje prazno: Disallow: /tag /. Ako koristite kategoriju, morate blokirati kategoriju u datoteci robot.txt: Disallow: /category /. Prema zadanim postavkama baza je oznaka ako je polje prazno: Disallow: /tag /. Ako koristite kategoriju, morate blokirati kategoriju u datoteci robot.txt: Disallow: /category /. Datoteke koje se uglavnom koriste za prikazivanje sadržaja blokirane su ispravnom robot txt datotekom za Wordpress:

WordPress ima neke datoteke i direktorije koji moraju biti blokirani svaki put. Katalozi koje korisnici moraju zabraniti - to je katalog standardnih WP direktorija tvrtke cgi-bin. Neki poslužitelji ne dopuštaju pristup cgi-bin direktoriju, ali ga korisnici moraju uključiti u direktivu disallow prije ispravnog konfiguriranja robota txt WordPressa. Ti direktoriji nemaju podatke koji su u početku korisni za tražilicesustavima, ali postoji iznimka, to jest, u direktoriju wp-content postoji poddirektorij pod nazivom prijenosi. Ovaj poddirektorij mora biti dopušten u datoteci robot.txt jer uključuje sve što se učitava pomoću značajke prijenosa WP medija. WordPress koristi oznake ili kategorije za strukturiranje sadržaja. Ako se koriste kategorije, kako bi se napravili ispravni roboti txt za Wordpress, kako je odredio proizvođač programa, potrebno je zaključati arhive oznaka za pretraživanje. Najprije provjerite bazu podataka tako da odete na upravljačku ploču & gt; Postavke & gt; "Permalink". Prema zadanim postavkama baza je oznaka ako je polje prazno: Disallow: /tag /. Ako koristite kategoriju, morate blokirati kategoriju u datoteci robot.txt: Disallow: /category /. Prema zadanim postavkama baza je oznaka ako je polje prazno: Disallow: /tag /. Ako koristite kategoriju, morate blokirati kategoriju u datoteci robot.txt: Disallow: /category /. Datoteke koje se uglavnom koriste za prikazivanje sadržaja blokirane su ispravnom robot txt datotekom za Wordpress:

Ranije je MODX Cloud omogućio korisnicima da kontroliraju ponašanje datoteke robots.txt radi održavanja na temelju prebacivanja u nadzornu ploču. Iako je to bilo korisno, mogli biste nasumce dopustiti indeksiranje na stranicama /dev stranicama prebacivanjem opcije na nadzornu ploču. Slično tome, indeksiranje na mjestu proizvodnje može se lako zabraniti. Danas usluga razmatra prisutnost datoteka robots.txt u datotečnom sustavu uz sljedeće iznimke: domena koja završava, modxcloud.com poslužit će kao smjernica Disallow: /za sve korisničke agente, bez obzira na prisutnost ili odsutnost datoteke. Za proizvodne web-lokacije koje primaju prave posjetitelje prometa, morat ćete koristiti vlastitu domenu ako korisnik želi indeksirati njihovu web-lokaciju. Neke organizacije koriste ispravan robots txt za modx za pokretanje više web-mjesta iz jedne instalacije pomoću konteksta. Slučaj u kojem se to može primijeniti bit će javni marketingweb-lokaciju u kombinaciji s mikro-stranicama odredišne stranice i, možda, nejavnim intranetom. Tradicionalno, to je bilo teško za instalacije s više korisnika, budući da dijele isti korijen mreže. MODX Cloud može to učiniti lako. Samo prenesite dodatnu datoteku na web-mjesto pod nazivom robots-intranet.example.com.txt s takvim sadržajem i blokirat će indeksiranje pomoću robota koji dobro funkcioniraju, a sva ostala imena hostova vraćaju se u standardne datoteke ako nema drugih specifičnih nazvanih čvorova. Robots.txt važna je datoteka koja korisniku pomaže povezati se s web-lokacijom na Googleu, glavnim pretraživačima i drugim web-lokacijama. Nalazi se u korijenu web-poslužitelja - datoteka upućuje web-pretraživače na indeksiranje web-lokacije, koja postavlja sve mape koje bi trebale indeksirati ili ne bi trebale indeksirati, pomoću skupa uputa koje se nazivaju protokol za uklanjanje robota. Primjer ispravnog robota txt za sve tražilice obots.txt je posebno jednostavan uz SeoToaster. Ima poseban izbornik na upravljačkoj ploči, tako da bot nikada neće morati naprezati da bi dobio pristup.

Ranije je MODX Cloud omogućio korisnicima da kontroliraju ponašanje datoteke robots.txt radi održavanja na temelju prebacivanja u nadzornu ploču. Iako je to bilo korisno, mogli biste nasumce dopustiti indeksiranje na stranicama /dev stranicama prebacivanjem opcije na nadzornu ploču. Slično tome, indeksiranje na mjestu proizvodnje može se lako zabraniti. Danas usluga razmatra prisutnost datoteka robots.txt u datotečnom sustavu uz sljedeće iznimke: domena koja završava, modxcloud.com poslužit će kao smjernica Disallow: /za sve korisničke agente, bez obzira na prisutnost ili odsutnost datoteke. Za proizvodne web-lokacije koje primaju prave posjetitelje prometa, morat ćete koristiti vlastitu domenu ako korisnik želi indeksirati njihovu web-lokaciju. Neke organizacije koriste ispravan robots txt za modx za pokretanje više web-mjesta iz jedne instalacije pomoću konteksta. Slučaj u kojem se to može primijeniti bit će javni marketingweb-lokaciju u kombinaciji s mikro-stranicama odredišne stranice i, možda, nejavnim intranetom. Tradicionalno, to je bilo teško za instalacije s više korisnika, budući da dijele isti korijen mreže. MODX Cloud može to učiniti lako. Samo prenesite dodatnu datoteku na web-mjesto pod nazivom robots-intranet.example.com.txt s takvim sadržajem i blokirat će indeksiranje pomoću robota koji dobro funkcioniraju, a sva ostala imena hostova vraćaju se u standardne datoteke ako nema drugih specifičnih nazvanih čvorova. Robots.txt važna je datoteka koja korisniku pomaže povezati se s web-lokacijom na Googleu, glavnim pretraživačima i drugim web-lokacijama. Nalazi se u korijenu web-poslužitelja - datoteka upućuje web-pretraživače na indeksiranje web-lokacije, koja postavlja sve mape koje bi trebale indeksirati ili ne bi trebale indeksirati, pomoću skupa uputa koje se nazivaju protokol za uklanjanje robota. Primjer ispravnog robota txt za sve tražilice obots.txt je posebno jednostavan uz SeoToaster. Ima poseban izbornik na upravljačkoj ploči, tako da bot nikada neće morati naprezati da bi dobio pristup.